技术解析|英伟达推出新一代GPU Rubin CPX

英伟达推新产品的速度,是很快的,特别是现在需要不断证明自己领先的位置。

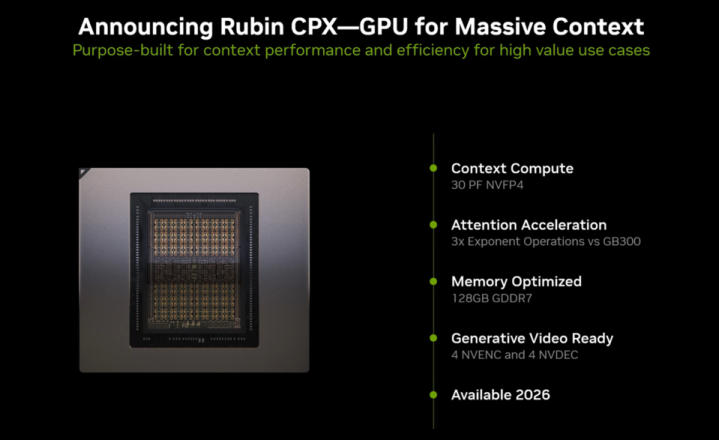

英伟达RubinCPX是GPU设计新的思路,采用了解耦推理的方式,把长上下文处理和生成任务拆分开来,还搭配大容量GDDR7显存打造了新的GPU。

这种设计考虑到了算力和内存需求的差异,能给百万Token推理、长视频生成以及复杂软件开发带来更高的效率和扩展性。

RubinCPX架构设计与技术特点

RubinCPX是专门针对大模型推理中“上下文阶段”和“生成阶段”的不同需求来设计的。

传统GPU靠HBM显存同时处理计算和带宽任务,但碰到百万Token的输入序列时,单一架构就显得有些吃力了。

RubinCPX会把长上下文处理交给专用的GPU来做,具体有这几个特点:

◎显存方面:单芯片搭载128GBGDDR7显存,相比HBM显存性价比更高,适合在机架级进行大规模部署。

◎算力表现:在NVFP4精度下能提供30PFLOPS的算力,专门优化了高吞吐的上下文解析任务。

◎视频处理能力:内置了四个NVENC和NVDEC引擎,很适合多模态AI的应用场景。

◎系统互联:能和VeraCPU、RubinHBMGPU以及ConnectX-9SuperNIC配合使用,在NVL144CPX机架内可以实现12.8Tbps的网络吞吐。

这个新的产品采用了单芯片设计,这样能减少延迟,保持性能的一致性,但在制造和散热方面会面临一些难度。看得出来,NVIDIA在规模训练、推理之间,一直在平衡成本和性能。

软件层面,Dynamo平台会协调上下文处理和生成处理这两部分工作。

解耦推理需要快速的KV缓存传输和灵活的内存管理,而Dynamo平台刚好能支持这套体系。

RubinCPX负责处理长序列输入,RubinGPU负责逐Token生成,两者通过高速连接和统一的软件栈配合,就能完成整个任务。

Part2

性能提升与应用价值

在VeraRubinNVL144CPX平台上,36颗VeraCPU、144颗RubinGPU和144颗RubinCPX搭配使用,总算力能达到8EFLOPS(NVFP4精度),比GB300NVL72高出7.5倍。

再加上100TB的存储和1.7PB/s的内存带宽,这个配置已经接近当前的极限水平了。

RubinCPX的性能优势很突出,主要体现在这三个方面:

◎长上下文推理:注意力机制的处理速度比GB300NVL72快3倍,在百万Token的场景下,延迟和效率都有明显改善。

◎视频与多模态处理:专用的编解码单元能适配长视频生成需求,很适合AI内容生产的场景。

◎推理经济性:解耦设计减少了对HBM显存的依赖,预计投资回报率(ROI)能达到30-50倍,投资效率大幅提高。

应用场景上,它不只是能用于AI推理,还能支持复杂的软件开发。

长序列处理能力可以从代码生成扩展到软件工程优化,在科研和视频生成领域,也能满足持续处理的需求。

从路线图来看,

◎RubinCPX会在2026年底推出,之后会和RubinGPU、VeraCPU组成异构生态。

◎到2027年,RubinUltra会加入12堆HBM4;

◎2028年,新架构Feyman也会跟进。

能看出NVIDIA一直在推进分层解耦和持续扩展的策略。

RubinCPX算是GPU发展的一个新方向,通过解耦和协作分工,来适应AI推理的需求,这体现出了设计上的灵活性和前瞻性。

百万Token推理从设想变成了现实,能为生成式AI应用的发展铺路。从2026年开始,随着RubinCPX的落地,异构架构和解耦推理或许会成为未来的主流方向。

特别声明:以上内容仅代表作者本人的观点或立场,不代表新浪财经头条的观点或立场。如因作品内容、版权或其他问题需要与新浪财经头条联系的,请于上述内容发布后的30天内进行。