研究人员提出AI对齐新方法, 通过交互式分解改善人类提供反馈过程

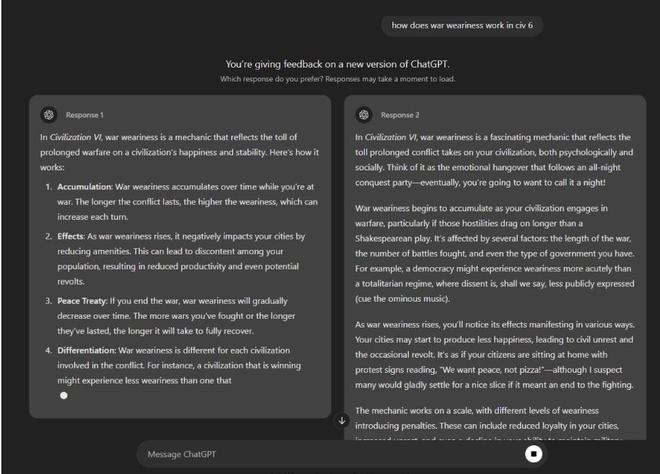

AI对齐(AIalignment)是目前大模型训练与优化过程中不可或缺的环节,目前广泛使用的方法包括基于人类反馈的强化学习(RLHF,ReinforcementLearningfromHumanFeedback)和直接偏好优化(DPO,DirectPreferenceOptimization),都需要收集高质量的人类偏好反馈数据。然而,现有界面要求标注者直接对比长篇文本,这种方式在认知上具有挑战性,特别是当文本较长或内容不熟悉时,用户往往无法精细地阅读、记忆所有内容以及识别文本中的所有差异,导致反馈质量不高,从而影响到AI对齐的质量。

目前尚未有研究提出如何系统地改善这类反馈质量。在近期一项研究之中,人机交互学者史丹青博士从用户反馈的角度进行展开,希望解决的核心问题是:

•如何提升人类反馈(特别是长篇文本比较场景)的准确性和质量?

•如何减少用户在提供反馈过程中的认知负担和出错率?

为此,他和所在团队提出并采用了“分解原则”[2],这是指将复杂的问题分解成更小、更容易判断的单一信息点,分别对每个组成部分进行判断,然后将各组成部分的预测结合起来,得出最终预测结果。这种方法旨在简化复杂任务为,在处理不确定性或复杂情况时特别有用,从而提高反馈质量。

据介绍,本研究基于分解原则提出了DxHF的方法,通过“交互式分解”的方式改善人类提供反馈的过程。具体成果包括:

•交互式分解技术:将长篇文本分解成简洁易读的单个陈述,方便用户快速浏览和对比。

•视觉辅助用户界面:通过对每个陈述信息进行相关性评分,并以视觉不透明度编码突出重点信息,同时连接语义相似的陈述信息,帮助用户快速识别关键差异。

实验中的关键发现包括:DxHF显著提高了用户反馈的准确性(平均提高约5%),特别是在用户对判断结果不确定时,准确性提升更明显(约6.4%);虽然略微增加了反馈用时,但能有效提高决策信心并降低用户认知负担。

据介绍,整个研究过程可以分为三个主要阶段:

第一阶段包括研究问题定义与理论方法探索。研究团队对大模型对齐中收集高质量反馈数据困难的问题进行了深入的文献回顾和需求分析,从人机交互角度出发,明确提出要探索一种新型用户界面技术,以降低用户的认知负担,提升反馈质量。在确定研究方向之后,研究团队查阅大量辅助人类决策的相关文献,定位到了有助于人们作出更加准确的判断的“分解原则”。受此启发,研究团队提出将文本分解为独立的、易于理解的简单陈述信息,从而使反馈的比较过程变得更加容易掌握。

第二阶段为技术实现与界面设计。基于分解原则,研究团队通过反复的内部讨论、原型设计与迭代,测试了一系列交互界面。这一阶段涉及到大量具体的设计决策,比如如何准确地将长句分解为单一的语义单元,如何突出显示最关键的部分,以及如何将两组相似文本之间的语义联系直观呈现出来。在正式投入实验前,团队也进行了大量的设计尝试、前期预研与消融实验测试,希望清晰又不失整体性地呈现完整的分解信息。

第三阶段为技术仿真与实验验证。在投入正式的用户实验之前,研究团队通过仿真对技术进行评估。仿真过程中使用AI来模拟真实用户,通过调整AI用户的“理性程度”,研究人员清晰地看到了分解技术在不同决策能力用户中起到了积极的作用。随后研究团队实施了一项大规模的在线众包实验,超过160名参与者通过网络众包平台参与,提供真实的反馈数据。研究人员从众包实验数据中观察到明显的效果:DxHF不仅显著提高了用户的反馈准确性,也帮助用户提升了决策信心。

在设计讨论过程中,项目面临如何同时兼顾文本整体性的理解与细节性的分析的问题。最终的设计灵感来自于一次研讨会上桌边的折叠宣传手册,他们发现可以通过折叠与拉伸的方法展示信息。于是,该团队借用该物理交互的隐喻来设计界面,不仅保留了整体阅读的完整性,也让用户可以自由地深入细节。在开展用户实验时,研究团队特别留意到参与者对这一设计的反应。参与者反馈了自己对于反馈中自由选择比较方式的偏好,对简单的问题比较无需展开细节减少了繁杂的信息负荷,而对复杂比较任务通过展开能够自由地探索更深层次的信息。

审稿人认为本研究所关注问题与当前AI领域关注的热点具有很强的相关性,其指出研究团队从人机交互的视角入手,探索如何缓解人类在AI对齐过程中所面临的复杂认知任务,并认为该方向十分具有前景。同时,审稿人认为本研究提出的方法不仅对AI对齐中高质量数据标注这一具体问题具有重要贡献,对长篇文本对比任务中人所面临的认知挑战方面具备更广泛的应用潜力,能够进一步拓展至其他需要用户快速做出多文本对比判断的场景,诸如法律文书比对、政策比较等信息检索和决策辅助领域中发挥作用,这些领域均对文本的精细比对提出了极高要求。

预计该方法可以广泛用于改进目前面向AI对齐的人类反馈数据采集流程,帮助构建更可靠、更符合人类偏好的大语言模型。另据悉,该项目的论文被用户界面软件与技术研讨会(UIST,UserInterfaceSoftwareandTechnology)2025接收,据了解UIST是是人机交互领域的顶会之一,将于2025年9月于韩国釜山召开,该会议方向主要集中在用户界面软件与硬件技术的创新。

本次论文的作者史丹青博士目前就职于英国剑桥大学工程系,担任副研究员(博士后),从事人智交互(Human-AIInteraction)的研究。此前,他曾就职于芬兰人工智能中心,博士毕业于同济大学,本科毕业于华东师范大学。他的研究致力于“让AI更懂人”,包含对人类行为计算建模与AI的交互式对齐。其学术成果多次获得人机交互与可视化领域顶级会议CHI2025、CHI2024、PacificVis24等最佳论文提名奖。

他与芬兰Aalto的AnttiOulasvirta教授和瑞典KTH的TinoWeinkauf教授组成的研究团队在人智交互领域长期合作,在该研究之前他们已经积累了一系列面向机器人领域的交互式AI对齐研究工作,包括通过交互式调节奖励函数来控制Agent的动作行为[2],以及运用层次分组可视化技术提升AI对齐的效率[3]。这次工作的重心则是希望将交互式AI对齐的工作从机器人领域扩展到大模型的应用中。

与此同时,本次研究项目是他在瑞士苏黎世联邦理工研究访问期间完成的,合作方的是MennatallahEl-Assady教授与程富瑞博士。MennatallahEl-Assady教授和程富瑞博士在交互式机器学习和可解释性机器学习,尤其是在大模型的交互式文本分析上有着大量的研究积累,这次合作将双方团队的优势加以有效结合,成功地将交互式AI对齐用于了大模型的文本分析。

参考资料:

1.Shi,Danqing,FuruiCheng,TinoWeinkauf,AnttiOulasvirta,andMennatallahEl-Assady.DxHF:ProvidingHigh-QualityHumanFeedbackforLLMAlignmentviaInteractiveDecomposition.ToappearinUIST2025.

2.ScottArmstrong,WilliamBDennistonJr,andMattMGordon.1975.Theuseofthedecompositionprincipleinmakingjudgments.Organizationalbehaviorandhumanperformance14,2(1975),257–263.

3.Shi,Danqing,ShibeiZhu,TinoWeinkauf,andAnttiOulasvirta.InteractiveRewardTuning:InteractiveVisualizationforPreferenceElicitation.In2024IEEE/RSJInternationalConferenceonIntelligentRobotsandSystems(IROS),pp.9254-9261.IEEE,2024.

4.Kompatscher,Jan,DanqingShi,GiovannaVarni,TinoWeinkauf,andAnttiOulasvirta.InteractiveGroupwiseComparisonforReinforcementLearningfromHumanFeedback.arXivpreprintarXiv:2507.04340(2025).